Recursos Humanos lleva años trabajando para hacer avanzar a las organizaciones en diversidad, inclusión, equidad, y la irrupción de la IA abre un nuevo reto relacionado con los datos y cómo deben reflejar las aptitudes, habilidades y potencialidades de los trabajadores y de los candidatos en un marco de equidad. ¿Cómo garantizar que esa tecnología no sólo no comprometa estos avances sino que los impulse aún más? En este Webinar del Campus IA+Igual exploramos los retos a los que se enfrentan los científicos de datos que trabajan en la Función RH, y más concretamente en el ámbito de los colectivos vulnerables. La plataforma InclunIA, de Fundación Once, ejemplifica el esfuerzo por generar un entorno laboral inclusivo para todos ellos.

En la sesión, dirigida por Ana Valera, experta en people analytics y colaboradora de las actividades de formación del Proyecto IA+Igual, han participado Borja García, gerente HIT de Fundación Once, compañía que ha colaborado activamente con el Proyecto IA+Igual, y Alberto García, investigador en IA de la Universidad de Navarra y miembro del equipo de Datai, partner académico del proyecto. A lo largo de la sesión han ido dando respuesta a cuestiones críticas que, en muchos casos, todavía están por construir y que precisamente por eso han de guiar los pasos a dar.

¿Tiene ética la IA? ¿Por qué la IA puede ser injusta? ¿Por qué decimos que la inteligencia artificial puede amplificar los sesgos humanos en lugar de corregirlos? ¿Dónde está el origen de este problema?

La IA no tiene ética propia, es la que le facilitan los seres humanos a través de la información con la que la alimentan. Cuando hablamos de inteligencia artificial nos referimos a sistemas matemáticos -los algoritmos- que aprenden patrones a partir de conjuntos de datos. Si los datos contienen errores, inexactitudes o prejuicios los algoritmos -y muchas veces es así porque no olvidemos que han sido creados a partir de información “humana”, de patrones-, es lógico que la IA los replique y que deduzca correlaciones inadecuadas, sesgadas o injustas. La IA no busca justicia, busca eficiencia o, lo que es lo mismo, resolver una tarea específica de la mejor y más rápida manera posible. Por eso es tan importante la supervisión humana no sólo de los datos, sino también de su proceso de aprendizaje y de los resultados que arroje el modelo que los procese. Por ejemplo, si en el conjunto de datos de entrenamiento existe una infrarrepresentación de algún colectivo, el propio modelo no va a ser consciente de esa desigualdad a menos que se le enteene de la manera adecuada.

¿Por qué los colectivos vulnerables suelen estar infrarrepresentados en las bases de datos?

Hay dos motivos para ello:

- El primero se debe a que históricamente estos colectivos han tenido menos acceso a oportunidades laborales y educativas, lo que se ha traducido en una falta de datos representativos en los sistemas y en los datos. Por eso, si entrenamos algoritmos con datos que no reflejan la diversidad de la población corremos el riesgo de que la IA replique o incluso amplifique los sesgos existentes en los datos.

- El segundo radica en que normalmente esos datos están protegidos como datos personales y privados que son y, por lo tanto, no pueden utilizarse en los datos de entrenamiento ni en el modelo.

En ambos casos las consecuencias son la discriminación y falta de igualdad de oportunidades a través de una toma de decisiones condicionada por el sesgo de los datos, especialmente en los procesos de reclutamiento, selección y promoción interna. En los dos primeros, los casos van desde asignarles perfiles laborales que realmente no se correspondan con su verdadero potencial hasta la propuesta de itinerarios formativos que no potencien sus auténticas capacidades. Y en la tercera, el problema es aún más sutil, porque si los algoritmos entrenados no tienen en cuenta los diferentes caminos que una persona con discapacidad puede tomar para desarrollar sus habilidades o si desconocen las capacidades en sí mismas y se centran únicamente en la discapacidad de las personas, las posibilidades de los colectivos vulnerables se ven mermadas en beneficio de otros perfiles más convencionales y más representados en los datos.

Las organizaciones han de asegurarse de que las bases de datos estén actualizadas y reflejen bien y de la manera más precisa posible la diversidad de habilidades y capacidades de todos los colectivos. Sobre todo cuando esas bases de datos se utilicen para extraer subconjuntos de datos. Han de crear modelos que tengan una representación equilibrada de los diferentes colectivos en los datos y que nos permitan optimizar la forma en que los algoritmos puedan reconocer las habilidades y las capacidades de todas las personas, independientemente de sus condiciones o diversidades. La unidad de medida han de ser las capacidades.

¿Cómo podemos identificar los sesgos en los datos?

Una de las de las primeras señales es la falta de diversidad en los perfiles de los candidatos o en las personas que hacen la formación de empleo, por ello es tan importante incorporar este análisis en la intermediación laboral con IA.

Y otro indicador es la falta de transparencia en los datos. Hemos de ser capaces de saber claramente de dónde vienen las ingestas masivas de datos, cómo han sido etiquetados, cómo han sido normalizados, en relación a qué muestra poblacional…, en definitiva, qué calidad tienen. Y para eso hemos de preguntarnos: ¿Tiene sentido lo que me dicen los datos, lo que me recomienda el algoritmo? Y si utilizo otra base de datos, ¿cambiaría el resultado? ¿Estamos entrenando el modelo con datos suficientes y significativos? ¿Son necesarios todos los datos para el fin que busco? ¿Puedo utilizarlos sin socavar el respeto a la privacidad de las personas?

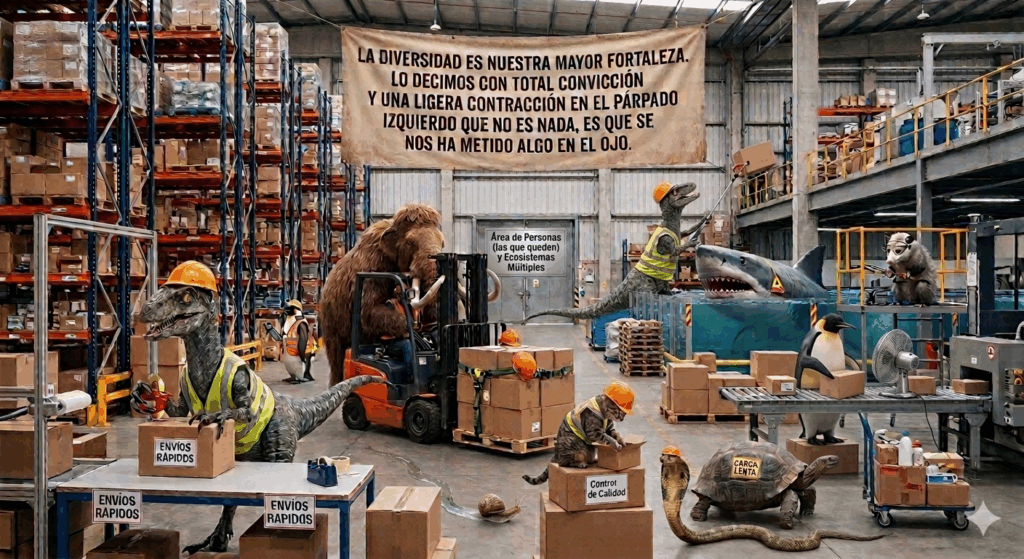

Hay revisar todo el ciclo de vida de los datos, desde su recogida, el motivo, cómo los estoy modificando, para qué los estoy usando, etc. Hay que trazar absolutamente todo y en ese viaje nos encontraremos con ciertos aspectos que son muy reveladores de cuándo algo no va bien. Un aspecto crucial en ello es que los equipos de científicos de datos sean multidisciplinares y diversos, que incorporen perfiles con formación humanística, filosófica y sociológica, porque ayudarán a plantearse muchas de esas preguntas y a darles respuesta entre todos sumando perspectivas.

¿Qué son los datos sintéticos y para qué se utilizan?

Los datos sintéticos son aquellos que se generan artificialmente en lugar de ser recolectados directamente de las fuentes del mundo real. En Fundación Once están trabajando con ellos y afirman que les permiten crear un conjunto de datos más equilibrados y representativos de colectivos que históricamente han estado infrarrepresentados. «Pero también nos ayudan en algo tan sencillo como identificar a las personas con baja cualificación respecto a los alta cualificación pero en base a sus habilidades, no a sus titulaciones», explica Borja García.

En definitiva, los datos sintéticos son útiles para superar la falta de datos reales sobre sobre los colectivos menos representados y a crear muestras que reflejen mejor la diversidad del mercado laboral. Por ello permiten corregir sesgos históricos al generar datos que promueven la equidad.

No obstante, su uso excesivo o incontrolado tiene el riesgo de que den lugar a modelos de IA erráticos. Es decir, si los datos generados no están suficientemente alineados con la realidad del mercado laboral o son demasiado diferentes de los datos reales, el modelo podría empezar a comportarse de manera inesperada, creando resultados menos precisos o incluso contradictorios. «Por eso en Fundación Once tomamos medidas como, por ejemplo, trabajar el equilibrio cuidadoso entre datos reales y sintéticos. Utilizamos los datos sintéticos solo cuando es estrictamente necesario para poder complementar aquellos grupos que están infrarrepresentados realmente en nuestros datos y siempre asegurándonos de que no se usen en exceso para que no distorsionen la realidad. Por eso es fundamental realizar validaciones periódicas que permitan comparar los resultados de modelos entrenados con datos sintéticos frente a los modelos entrenados con datos reales y ajustar así la ponderación de las variables en caso necesario”.

Diseñado como un modelo de IA “in house”, el objetivo de InclunIA es poner a las personas en el centro de la toma de decisiones de la intermediación laboral y a la IA como el compañero avanzado, más rápido y eficiente a la hora de hacer propuestas pero no en la toma de la decisión final, que siempre corresponde a las personas.

El proyecto está liderando el cambio en la manera en la que Fundación Once aborda la inclusión laboral de las personas con discapacidad. “Nuestro enfoque es no sólo el de optimizar los procesos de selección, sino el de asegurar también la representatividad y equidad de los datos con los que entrenamos el modelo. Trabajamos de manera muy muy proactiva para corregir la infrarrepresentación de colectivos vulnerables a través de un «etiquetado» de competencias basado en habilidades, para identificar comportamientos anómalos y para poder corregirlos lo más rápidamente posible -afirma Borja García-. Para ello estamos utilizando datos sintéticos que nos permiten controlar la presión de los modelos sin distorsionarlos. Los resultados que estamos obteniendo por parte de nuestros técnicos de selección y de nuestros orientadores laborales son muy positivos, y eso nos da confianza en la idea de que una IA ética y responsable es posible y que ello representa la posibilidad de abrir la puerta de las opciones laborales a muchas personas”.